Ultima newsletter del 2024, direi che ci sono un bel po’ di cose da dire, a partire da un ringraziamento per quello che mi scrivete in relazione al mio ultimo libro… sta per uscire anche l’edizione inglese…

Nel frattempo le notizie relative al digitale non si fermano, anche se i 12 giorni di “sorprese” di OpenAI sono terminate con il botto, con l’apertura ai test relativi al futuro modello LLM.

Provo a partire da un tema preoccupante.

Le immagini dicono molto di noi

Parecchi anni fa avevo suscitato molto scalpore mostrando in TV a Netc@fé (per chi se la ricorda), un’immagine che raccontava quali dati si celavano dietro un’immagine di Facebook. Era il 2012, l’intelligenza artificiale generativa non era nemmeno nei pensieri dei ricercatori, eppure c’erano dati interessanti (chi c’era, una descrizione dell’ambiente, l’etnia, i colori).

Capite che Meta ha un patrimonio di informazioni infinito da cui attingere.

Ma gli algoritmi cambiano.

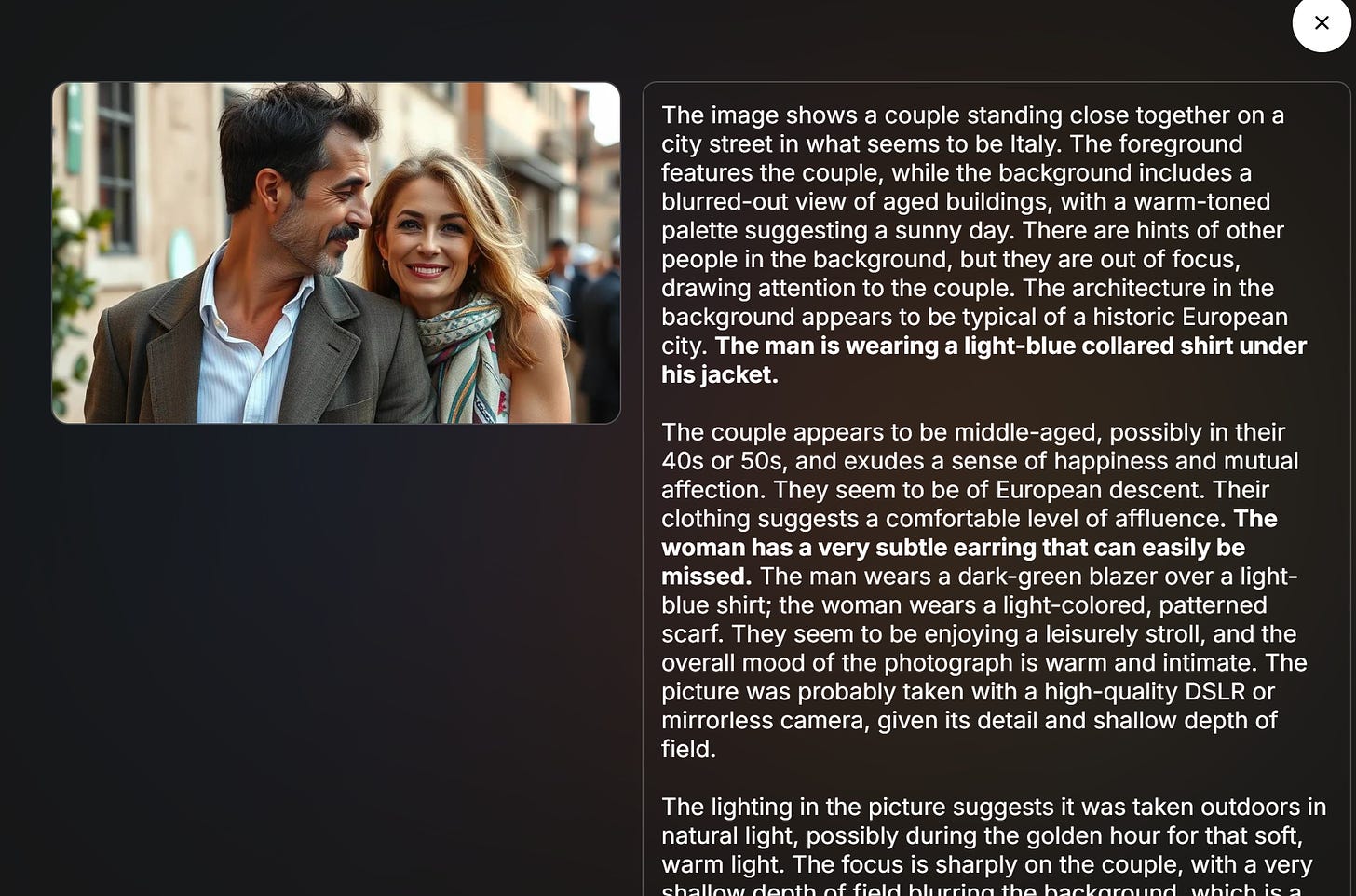

Provate a chiedere a questo sito, dopo aver caricato un’immagine, magari anche generata dall’AI, che informazione è in grado di estrapolare e ne rimarrete stupiti. Qui un semplice esempio da un’immagine creata con l’AI!

Oggi i sistemi sono davvero molto sofisticati, molto sofisticati, troppo sofisticati per cui chiunque è in grado di estrapolare informazioni dettagliate dalle nostre vite.

Fare attenzione e raccontarlo credo che sia un dovere, per cui inizierò ogni discorso che tengo nelle scuole da qui nel 2025.

Il robot precisissimo

Quando si parla delle capacità dei robot di emulare il comportamento umano si mostrano le varie braccia meccaniche in una catena di montaggio.

Vi lascio il video del robot di Toyota perché così vi rendete conto che oltre alla meccanica c’è una precisione che non appartiene alla nostra specie.

Dovremo abituarci a questi elementi alieni che ci circonderanno, alimentando i pensieri degli scettici e la loro preoccupazione di comprendere a cosa serviremo!

Instagram e l’editing dei video con l’AI

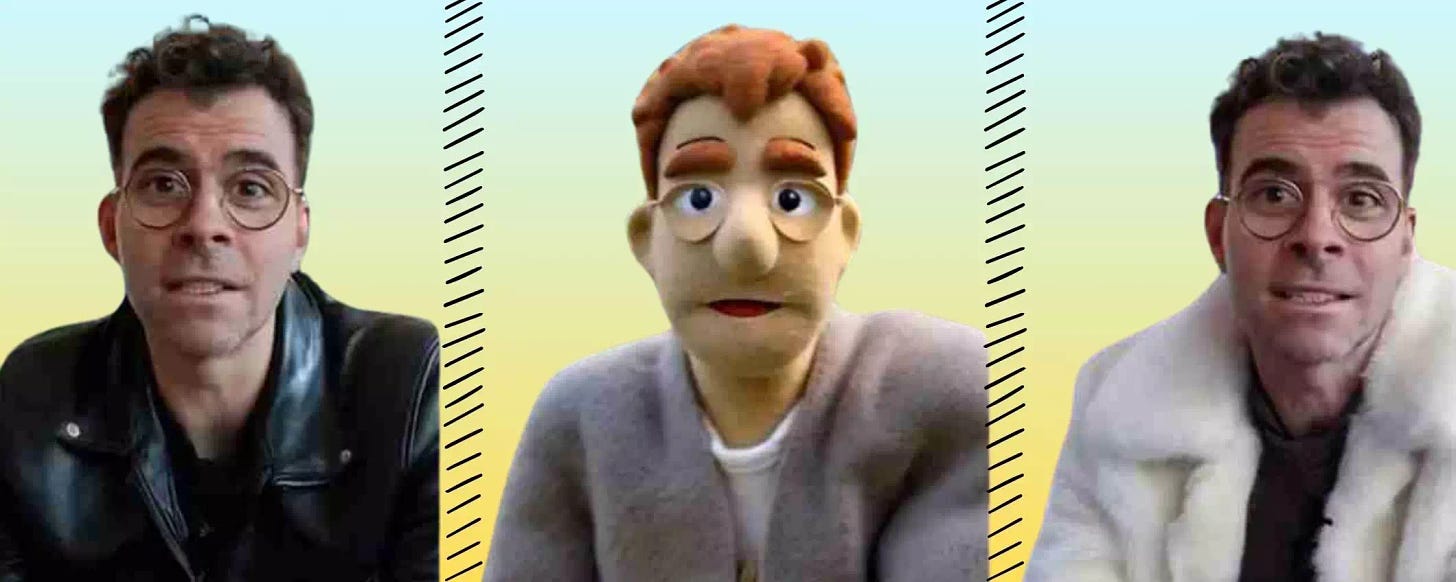

Instagram sta lavorando a strumenti di editing tramite AI generativa per i creatori di contenuti, che potranno trasformare la vista delle loro video con semplici promt di testo. Adam Mosseri, capo di Instagram, ha presentato questi strumenti facendo vedere come potranno essere utilizzati.

Avranno successo?

Apriamo il capitolo Google vs OpenAI

La rivalità tra Google e OpenAI è visibile nei loro ultimi annunci. Mentre ciascuna azienda cerca di superare l’altra, il risultato è un’accelerazione nello sviluppo di capacità avanzate di IA. Questa competizione spinge entrambe le aziende a migliorare costantemente le loro offerte, beneficiando gli utenti finali con tecnologie più sofisticate.

Gemini 2.0 (uno che cerca e ragiona) e NotebookLM

Google ha deciso di fare le cose in grande con l’AI, si era capito da tempo. Partiamo con NotebookLM, visto che lo uso per fare il riassunto podcast di questa newsletter da qualche settimana. L’applicazione ha ricevuto aggiornamenti significativi, incluso un nuovo design e una modalità interattiva per trasformare i documenti in elementi interattivi, con tanto di domande e risposte in tempo reale

E poi ha lanciato la versione avanzata del modello Gemini 2.0, dotato di capacità di ragionamento migliorate, presentando una sfida diretta ai modelli di OpenAI.

La funzione Grounding, capace di fare ricerche sul web da aggiungere nelle risposte, sta riscuotendo molto successo, una risposta a Perplexity e SearchGPT che sta stupendo.

Google punta molto sui video

Google ha presentato Veo 2 e Imagen 3.

Veo 2 è un modello di video generazione che crea video di alta qualità in numerose categorie e stili. Nei confronti dei modelli concorrenti, Veo 2 ha raggiunto risultati incredibili e difficilmente distinguibili dall’occhio umano.

Hollywood ha iniziato a interessarsi agli algoritmi.

Imagen 3 è stato migliorato nel campo della generazione di immagini. Ora può creare immagini più luminose in categorie diverse, come ad esempio il realismo al contrario dell'impressionismo. L'aggiornamento Imagen 3 inoltre mira i prompt in maniera più precisa e migliora i dettagli e le texture nella creazione della scena.

Sfortunatamente la citazione da segnalare è la seguente: "Whisk: a fun new tool that lets you prompt with images to visualize your ideas", che è una citazione inglese che si traduce in italiano con "Whisk, uno strumento divertente per generare immagini con l'ausilio di iconografia già esistente".

E poi c’è Whisk, un progetto sperimentale che consente di alimentare canzoni con immagini, remixa tutto per creare qualcosa di unico ed esclusivo.

Nel frattempo, non è tutto oro ciò che luccica. Infatti, Google e la legge sulla concorrenza: anche in Giappone è sotto accusa.

Ormai è un'assedio.

OpenAI si sta dando da fare

I 12 giorni di sorprese di OpenAI hanno catalizzato l’attenzione dei media. Qualcosa, come la voce di babbo natale per ChatGPT non aveva grande significato, mentre l’uso dentro WhatsApp o un numero verde negli USA, per quanto banale, permette di dialogare in modo semplice, senza installare nulla.

Ma l’introduzione della ricerca sul web in ChatGPT rappresenta un significativo miglioramento nell’utilizzo delle AI conversazionali. Questa funzionalità consente agli utenti di ricevere risposte più complete e contestuali, rendendo l’interazione con l’IA più utile e pertinente.

Anche per i programmatori ci sono state novità concrete, con l’accesso all’API per il modello 01 di OpenAI, si possono integrare capacità avanzate di ragionamento nelle applicazioni delle varie aziende. Questo non solo amplia le possibilità di utilizzo dell’IA, ma democratizza anche l’accesso a tecnologie avanzate, permettendo a più aziende di sfruttare l’IA per migliorare i loro servizi.

Il nuovo modello o3 di OpenAI rappresenta un punto di svolta epocale nelle capacità dell'intelligenza artificiale. Diverso da un semplice aggiornamento, o3 muta radicalmente il modo in cui l'AI apprende e generalizza. Con risultati "impossibili", il modello ridefinisce ciò che si considerava possibile per un'intelligenza artificiale.

I Ray-Ban traducono e leggono ciò che vedono

Meta aggiorna Ray-Ban Meta con nuove funzionalità AI, come la possibilità di avere una conversazione continua con Meta AI e tradurre da una lingua all'altra. Live AI consente di conversare con Meta AI senza dover utilizzare il comando di attivazione "Hey, Meta" e di interrompere la conversazione per fare domande o cambiare argomento. Live AI è anche compatibile con la visione in tempo reale e consente ai portatori di chiedere domande su ciò che vedono nel momento in cui lo vedono, come ad esempio vedere cosa c'è intorno. Europa esclusa, con tanto di intervista per raccontare perché Meta non è felice dei regolamenti europei.

AI al servizio dei programmatori

GitHub annuncia la disponibilità di GitHub Copilot Free, un sistema di assistenza ai programmatori gratuito e integrato con Visual Studio Code. Chi utilizza un account personale su GitHub può accedere a 2000 suggerimenti di codice e 50 messaggi di chat al mese. Le opzioni di assistenza offerte da Copilot Free includono la possibilità di chiedere spiegazioni per il codice esistente o di risolvere bug.

Bing Image Creator si rifà il trucco

Bing Image Creator sta continuando a sorprendere. Lanciato nel marzo 2023, hanno già creato miliardi di immagini. Con l'aiuto dell'AI, è possibile generare immagini da zero e portare le idee alla vita in pochi secondi. La tecnologia di ultima generazione e il modello AI basato su DALL-E 3 vedono nuove potenzialità che velocizzano la creazione di immagini. Arrivano funzionalità come la possibilità di generare immagini direttamente alla barra di ricerca di Bing e Microsoft Edge, rendendo il processo di creazione visiva ancora più veloce.

L’ultima puntata del Late Tech Show

Il cloud si sta adeguando a fornire soluzioni efficienti riguardanti l'intelligenza artificiale, con soluzioni sempre più avanzate e semplici da usare, nel senso che l'uso è semplice e la complessità che ci sta dietro resta nascosta. Una ricerca evidenzia che le aziende italiane sono preoccupate per l'aumento dei rischi derivanti dall'intelligenza artificiale, tra cui la perdita di dati, i danni reputazionali e i rischi finanziari. Il 50% delle aziende italiane investe in formazione sulla sicurezza informatica e l'80% prevede di farlo in futuro, a dimostrazione della crescente consapevolezza dell'importanza di questo tema. Oltre alla sicurezza informatica, l'intelligenza artificiale sta trasformando anche il modo in cui lavoriamo. Il lavoro ibrido e lo smart working sono diventati la norma e le aziende si stanno adattando a questa nuova realtà investendo in tecnologie che consentono una collaborazione efficace a distanza. E poi la NIS2 ormai è qui e le aziende se ne devono occupare, ponendo attenzione sugli aspetti ch riguardano l'intera filiera della sicurezza informatica.

Ospiti: Antonio D'Ortenzio di AWS, Cesare D'Angelo di Kaspersky, Denis Valter Cassinerio di Acronis, Fabio Bielli di Bip

In versione Youtube con i capitoli.

Vi lascio anche un link per i miei libri, caso mai vi venisse voglia di leggere.

Buon Natale e puntiamo al 2025!

LASCIAMI UN MESSAGGIO

Fammi sapere cosa ti ha colpito delle cose che faccio o racconto nei vari eventi, o di quello che ascolti al Late Tech Show, piuttosto che negli SmartBreak (e dal podcast "Vita da ufficio") o che leggi nella newsletter Techy.

Ti prego di farmi conoscere cosa pensi possa essere migliorato, aiutami con le critiche, e soprattutto quali temi vorresti che venissero approfonditi o trattati.

GRAZIE

Un blog per parlare di cultura digitale, prodotti, servizi e molto, molto di più.

Un blog per parlare di cultura digitale, prodotti, servizi e molto, molto di più.